L’ordinateur est-il né en 1640 avec l’invention de la machine à calculer conçue par Pascal ? Ou plutôt en 1810 avec le système de cartes perforées créé par Joseph-Marie Jacquard pour automatiser ses métiers à tisser ? Et s’il était né avec l’invention du boulier ? Pourquoi pas !

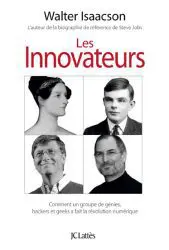

« La narration historique des inventions qui ont créé l’ère numérique a de nombreux fils conducteurs », écrit Walter Isaacson au début de son formidable essai, Les innovateurs1. Comme il lui fallait tout de même fixer une date et mettre un nom sur l’acte de naissance de l’ordinateur, Isaacson choisit celui d’une jeune femme anglaise du XIXe siècle du nom d’Ada Lovelace. Mathématicienne exceptionnellement douée, dotée de surcroît d’une vive imagination poétique – elle était la fille du poète Lord Byron –, elle ajouta, en 1842, des notes sur la « machine analytique » inventée par Charles Babbage pour exécuter une gamme variée d’opérations mathématiques. Ces notes allaient passer à l’histoire.

« La narration historique des inventions qui ont créé l’ère numérique a de nombreux fils conducteurs », écrit Walter Isaacson au début de son formidable essai, Les innovateurs1. Comme il lui fallait tout de même fixer une date et mettre un nom sur l’acte de naissance de l’ordinateur, Isaacson choisit celui d’une jeune femme anglaise du XIXe siècle du nom d’Ada Lovelace. Mathématicienne exceptionnellement douée, dotée de surcroît d’une vive imagination poétique – elle était la fille du poète Lord Byron –, elle ajouta, en 1842, des notes sur la « machine analytique » inventée par Charles Babbage pour exécuter une gamme variée d’opérations mathématiques. Ces notes allaient passer à l’histoire.

Une « machine universelle » pouvait, disait-elle, être programmée et reprogrammée pour exécuter une série illimitée de tâches interchangeables. Ces opérations ne se limitaient pas aux mathématiques et aux nombres, la machine pouvait faire la même chose avec tout ce qui était susceptible de s’exprimer par symboles (paroles, musique, logique, etc.). Enfin, dans ses notes, la jeune Anglaise démontrait clairement qu’elle comprenait le fonctionnement de ce que nous appelons aujourd’hui un programme informatique ou algorithme.

De l’invention de la machine de Babbage et de la publication des notes d’Ada Lovelace à la fabrication du premier ordinateur, il fallut cent ans. Le processus se fit lentement par l’accumulation d’inventions techniques petites et grandes. Avec le développement de la puissance de traitement des machines à calculer qu’avait encore accéléré la perspective de la guerre dans les années 1930, venait la nécessité de traduire les problèmes concrets du monde réel en équations mathématiques qu’on soumettrait ultérieurement à la machine sous forme d’instructions. Comme ce travail de programmation était long, fastidieux, routinier et peu valorisé, ce champ d’activité fut laissé aux femmes. C’était bien avant que la programmation ne devienne aussi importante, et parfois plus importante, que l’architecture des machines pour lesquelles elle était faite.

Finalement, c’est en 1945 qu’un premier ordinateur devint totalement opérationnel. Il fut baptisé ENIAC, acronyme d’Electronic Numerical Integrator and Computer. Si tout le monde est d’accord pour reconnaître que les grands théoriciens de l’ordinateur universel furent le Hongrois John von Neumann et le Britannique Alan Turing, la paternité de « l’objet » ENIAC était plus nébuleuse à établir et fut l’objet de nombreux litiges. Ces batailles autour des brevets d’invention inauguraient un débat – qui dure encore maintenant – entre les tenants d’une technologie partagée et les tenants de la propriété intellectuelle exclusive. À titre d’exemple, Internet s’est développé principalement autour de l’idée de partage des connaissances et des banques de données en « open source », alors que l’industrie du matériel informatique, électronique et des semi-conducteurs défend, pour l’intérêt de ses investisseurs, la propriété intellectuelle protégée.

La grande révolution, le grand bond en avant en matière d’informatique s’est fait avec la création du transistor dans les laboratoires Bell, le 16 décembre 1947 très exactement. Isaacson écrit que l’apparition du transistor « fut pour l’ère numérique ce que la machine à vapeur fut pour la Révolution industrielle ». En remplaçant les tubes électroniques, le transistor, plus petit, plus efficace, moins énergivore, inaugurait l’ère de la miniaturisation des machines informatiques. D’autres inventions subséquentes, comme les microprocesseurs, allaient permettre d’en graver des millions sur de minuscules puces électroniques. Ainsi, la puissance de millions d’ENIAC pouvait maintenant se loger non seulement à l’intérieur des ogives des fusées spatiales, mais également dans des ordinateurs qu’on tiendrait sur ses genoux, dans des calculatrices et des lecteurs de musique portables. Le développement de l’ordinateur tombait en quelque sorte entre les mains de ses utilisateurs.

Pour concrétiser ce que laissaient entrevoir les avancées technologiques, il fallait un milieu incubateur. Le hasard voulut que ce soit autour de la baie de San Francisco que naquit l’ordinateur personnel. Au cours des années 1960, beaucoup d’ingénieurs y avaient immigré, attirés par les emplois qu’offraient les Westinghouse, Lockheed et autres fournisseurs de l’armée américaine. Puis y débarquèrent les « hackers » (dans le sens d’innovateurs) du Massachusetts Institute of Technology (MIT) et du milieu universitaire en général. Enfin, c’est à San Francisco que se manifesta avec le plus de force le mouvement de ce que l’on a appelé la contreculture, qui allait envahir l’Amérique dans les années 1960 et 1970.

Ce mouvement englobait aussi bien les hippies amateurs de drogues, les idéalistes communautaristes prônant le retour à la terre, les activistes opposés à la guerre du Vietnam que les maniaques d’électronique et les bidouilleurs de génie en quête du Saint Graal informatique, l’ordinateur personnel. Ces esprits libertaires, dédaigneux de la hiérarchie, désirant une civilisation du partage et un égalitarisme universel, ont profondément marqué la culture à partir de laquelle ont été conçus les nouveaux outils informatiques. Ainsi, la création du Web permit un libre accès aux données. C’est pour stimuler la fabrication participative de grands outils culturels que fut inventé Wikipédia. C’est pour favoriser une communication plus facile, plus large et plus immédiate que furent créés le courrier électronique, Facebook, Twitter et autres médias sociaux.

Maintenant que l’être humain dispose d’outils qui lui permettent « d’augmenter » son intelligence et son pouvoir d’action, les laboratoires s’affairent à créer des robots dotés d’une intelligence propre, donc capables de faire leurs propres choix. En Amérique comme en Europe, des équipes sont même à l’œuvre pour construire des processeurs informatiques « neuromorphiques », c’est-à-dire fonctionnant à l’image des neurones du cerveau. Peut-être sommes-nous à la veille de voir se réaliser le vieux rêve de l’humanité, à savoir donner la vie à un être-machine créé de nos propres mains. À suivre !

Biographe de Steve Jobs, d’Einstein et de Benjamin Franklin, Walter Isaacson sait relever le défi de rendre accessible à un large public l’histoire d’une révolution qui prend sa source dans des connaissances très pointues, ici les mathématiques et l’ingénierie. En bon journaliste vulgarisateur, il sait expliquer en évitant le jargon scientifique. D’ailleurs, si la science passionne Isaacson, ce qui l’intéresse tout autant ce sont les hommes et les femmes qui sont à l’origine de la révolution numérique. Comme quoi, tout autant qu’une aventure scientifique, la révolution numérique fut et reste aussi une aventure humaine, nous rappelle Isaacson. Les innovateurs est un livre fouillé sans être savant qui plaira aux esprits curieux.

1. Walter Isaacson, Les innovateurs, Comment un groupe de génies, hackers et geeks a fait la révolution numérique, trad. de l’américain par Bernard Sigaud, Lattès, Paris, 2015, 696 p. ; 39,95 $.